Big Data ไม่ได้เป็นเพียงแค่ที่เก็บของ

Big Data ไม่ได้เป็นเพียงแค่ที่เก็บของ การจะเก็บข้อมูลขนาดใหญ่ได้นั้น จำเป็นต้องมีองค์ประกอบ ได้แก่ การนำเข้าข้อมูล การประมวลผลข้อมูล การวิเคราะห์ข้อมูล และการนำเสนอข้อมูล

จากการที่ผมมีโอกาสได้พูดคุยกับคนรู้จักหลายคนเกี่ยวกับเรื่อง Big Data ไม่ว่าจะเป็นเพื่อนฝูง ลูกศิษย์ หรือคนรู้จักในภาคธุรกิจ ผมพบว่าคนจำนวนไม่น้อยยังขาดความเข้าใจในองค์ประกอบของ Big Data เพราะกลายเป็นว่าเมื่อพูดถึง Big Data คนส่วนใหญ่จะนึกถึงที่เก็บของขนาดใหญ่ (บางคนเรียกว่าที่เก็บขยะขนาดใหญ่ด้วยซ้ำ!) อันนี้จะโทษกันก็ไม่ได้ เพราะชื่อ Big Data ก็สื่อให้คิดแบบนั้นเสียด้วย

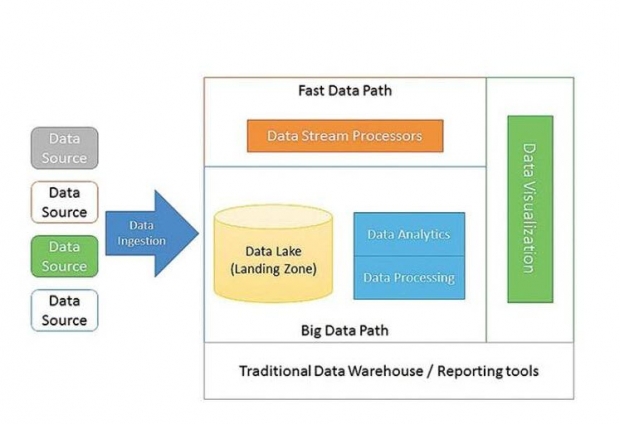

จริงอยู่ครับที่เรื่องการเก็บข้อมูลขนาดใหญ่จะเป็นเรื่องสำคัญของ Big Data แต่สำหรับ Big Data นั้น มันมีอะไรมากกว่านั้น เพราะการที่จะเก็บข้อมูลขนาดใหญ่ได้นั้น จำเป็นต้องมีองค์ประกอบอื่น ๆ ด้วย ได้แก่ การนำเข้าข้อมูล (Data Ingestion) การประมวลผลข้อมูล (Data Processing) การวิเคราะห์ข้อมูล (Data Analytic) และการนำเสนอข้อมูล (Data Visualization)

มาดูกันที่การนำเข้าข้อมูลหรือ Data Ingestion กันก่อน เรื่องนี้เป็นสิ่งที่หลาย ๆ คนมักจะมองข้าม ทั้ง ๆ ที่เป็นเรื่องจุกจิกไม่ใช่น้อย ต้องไม่ลืมว่า แหล่งข้อมูลที่เรามักจะนำเข้ามาใส่ใน Big Data นั้นมีความหลากหลาย มีทั้งที่อยู่ในหน่วยงานของเรา หรือมาจากแหล่งข้อมูลภายนอก นอกจากนี้ ความแตกต่างของแหล่งข้อมูลก็มีมาก ไม่ว่าจะเป็นเรื่องรูปแบบของข้อมูล ความถูกต้องของข้อมูล ความต้องการด้านความครบถ้วนของข้อมูล รวมไปถึงความเร็วของข้อมูลที่เข้ามา หลาย ๆ ครั้งผมพบว่าแค่เอาข้อมูลเข้ามาใส่ถัง Big Data ก็เป็นเรื่องที่น่าปวดหัวแล้วครับ

เมื่อเอาข้อมูลเข้ามาได้แล้ว ข้อมูลอาจจะถูกจับให้วิ่งไป 2 สาย สายหนึ่งคือ Big Data Path ซึ่งจะเป็นการนำข้อมูลมาเก็บไว้ในถังเก็บ โดยปกติแล้ว ถังเก็บนี้บางที่จะเรียก Data Lake บางที่เรียก Landing Zone ซึ่งมักจะเป็นการใช้ HDFS หรือ NoSQL ในการเก็บข้อมูล ซึ่งจะทำให้ข้อมูลที่จัดเก็บอยู่ในลักษณะ Data-At-Rest เพื่อรอการนำไปประมวลต่อไป

ในการประมวลผล Data-At-Rest นั้นจะมีการประมวลผลเป็นก้อนใหญ่ ๆ หรือที่เรียกกันว่า Batch Processing โดยใช้เครื่องมืออย่างเช่น Hadoop หรือ Spark มาทำการประมวลผลขั้นพื้นฐาน เช่น การนับ การจัดกลุ่ม การคำนวณเชิงสถิติ หลังจากนั้น ก็นำข้อมูลไปประมวลผลเชิงวิเคราะห์ชั้นสูงด้วยเทคนิคการเรียนรู้ของเครื่อง (Machine Learning) เช่น การวิเคราะห์ว่าลูกค้าของเรานั้นน่าจะมีไลฟ์สไตล์แบบไหน โดยใช้ข้อมูลพฤติกรรมของลูกค้าที่ได้ถูกรวบรวมและผ่านการประมวลผลขั้นพื้นฐานมาแล้ว หรือการคาดการณ์ว่าลูกค้าปัจจุบันของเรารายใดบ้าง มีแนวโน้มที่จะเลิกใช้บริการของเรา โดยให้ระบบทำการเรียนรู้ ค้นหาข้อสรุปลักษณะที่สำคัญของกลุ่มอดีตลูกค้าที่เลิกใช้บริการของเราไป แล้วนำมาเปรียบเทียบกับลูกค้าปัจจุบัน เพื่อหาลูกค้าที่เข้าข่ายจะเลิกใช้บริการในอนาคต

ข้อมูลที่นำเข้ามา นอกจากจะถูกจับไปเป็น Data-At-Rest แล้ว อาจจะถูกจับวิ่งไปในสาย Fast Data Path กลายเป็น Data- In-Motion ได้ โดยข้อมูลประเภทนี้มักจะเป็นข้อมูลที่ต้องถูกประมวลผลแบบ Real-Time เพื่อช่วยให้ระบบสามารถตอบสนองกับเหตุการณ์ได้อย่างทันท่วงที เช่น การนำข้อมูลการเข้าใช้งานเว็บไซต์ของหน่วยงานมาวิเคราะห์แบบเรียลไทม์ (Real-Time) ผ่าน Fast Data Path เพื่อพิจารณาว่ามีผู้ไม่ประสงค์ดีกำลังทำการงัดแงะเว็บไซต์เราหรือไม่ ซึ่งเราต้องวิเคราะห์ทันที ไม่สามารถจะรอไปอีก 2-3 ชม.ค่อยพิจารณาได้

นอกจากการประมวลผลแล้ว องค์ประกอบที่สำคัญอีกอย่างหนึ่งของ Big Data คือการนำข้อมูลมาแสดงผล หรือ Data Visua lization ซึ่งมีความสำคัญอย่างมาก ทั้งนี้เพราะหลายครั้ง เรามักจะมีสมมุติฐานเกี่ยวกับสิ่งที่เราสงสัย แต่เราไม่สามารถจะระบุออกมาได้อย่างชัดเจนเป็นกฎหรือเป็นรูปแบบเพื่อนำไปวิเคราะห์โดยอัตโนมัติได้ ดังนั้น การที่เรามีเครื่องมือที่ช่วยให้เราสามารถดูข้อมูลจำนวนมาก ในหลากหลายมุมมอง และหลากหลายระดับของความละเอียด เพื่อมองหารูปแบบที่สะดุดตา ก็จะเป็นประโยชน์อย่างมากในการทำความเข้าใจข้อมูลที่มีอยู่ เพื่อใช้ในการหาคำตอบกับโจทย์ที่เราตั้งขึ้นอย่างเป็นระบบ ซึ่งสุดท้าย คำตอบเหล่านี้ ก็อาจจะถูกนำกลับไปเป็นสูตรในการวิเคราะห์ หรือรูปแบบเงื่อนไขที่จะใช้ตรวจจับใน Fast Data Path อีกทีหนึ่ง

ก่อนจะจบ ผมอยากจะฝากว่า ถึงแม้ว่า Big Data จะกลายเป็นเครื่องมือสำคัญในการวิเคราะห์ข้อมูลขององค์กร แต่นั่นก็ไม่ได้หมายความว่าระบบรายงาน ระบบคลังข้อมูล และระบบ Business Intelligence ที่มีอยู่เดิมของหน่วยงานจะหายไป เพราะทั้ง 2 ส่วนนั้นมุ่งเน้นการทำงานที่ต่างระดับกัน โดยระบบรายงานต่าง ๆ ที่มีอยู่เดิมก็จะยังถูกใช้งานอยู่ในส่วนของ Operational Report แต่ส่วน Big Data นั้นจะถูกนำมาใช้ในการวิเคราะห์เพื่อการตัดสินใจ.

ที่มา:.jpg)

ไอทีจีเนียส เอ็นจิเนียริ่ง (IT Genius Engineering) ให้บริการด้านไอทีครบวงจร ทั้งงานด้านการอบรม (Training) สัมมนา รับงานเขียนโปรแกรม เว็บไซต์ แอพพลิเคชั่น งานออกแบบกราฟิก และงานด้าน E-Marketing ที่กำลังได้รับความนิยมในปัจจุบัน ทั้ง SEO , PPC , และ Social media marketting

ติดต่อเราเพื่อสอบถามผลิตภัณฑ์ ขอราคา หรือปรึกษาเรื่องไอที ได้เลยค่ะ

Line : @itgenius (มี @ ด้านหน้า) หรือ https://lin.ee/xoFlBFeFacebook : https://www.facebook.com/itgeniusonline

Tel : 02-570-8449 มือถือ 088-807-9770 และ 092-841-7931

Email : contact@itgenius.co.th

คำค้นหา : การจะเก็บข้อมูลขนาดใหญ่ได้นั้น จำเป็นต้องมีองค์ประกอบ การนำเข้าข้อมูล การประมวลผลข้อมูล การวิเคราะห์ข้อมูลการนำเสนอข้อมูลคนจำนวนไม่น้อยยังขาดความเข้าใจในองค์ประกอบของ Big Dataเมื่อพูดถึง Big Data คนส่วนใหญ่จะนึกถึงที่เก็บของขนาดใหญ่ ในการประมวลผล Data-At-Rest นั้นจะมีการประมวลผลเป็นก้อนใหญ่ ๆ องค์ประกอบที่สำคัญอีกอย่างหนึ่งของ Big Data คือการนำข้อมูลมาแสดงผล