สร้าง REST API ด้วย Python FastAPI ครบวงจร

ในยุคที่แอปพลิเคชันและเว็บไซต์ต้องสื่อสารกับระบบหลังบ้านด้วย API เป็นหลัก การพัฒนา REST...

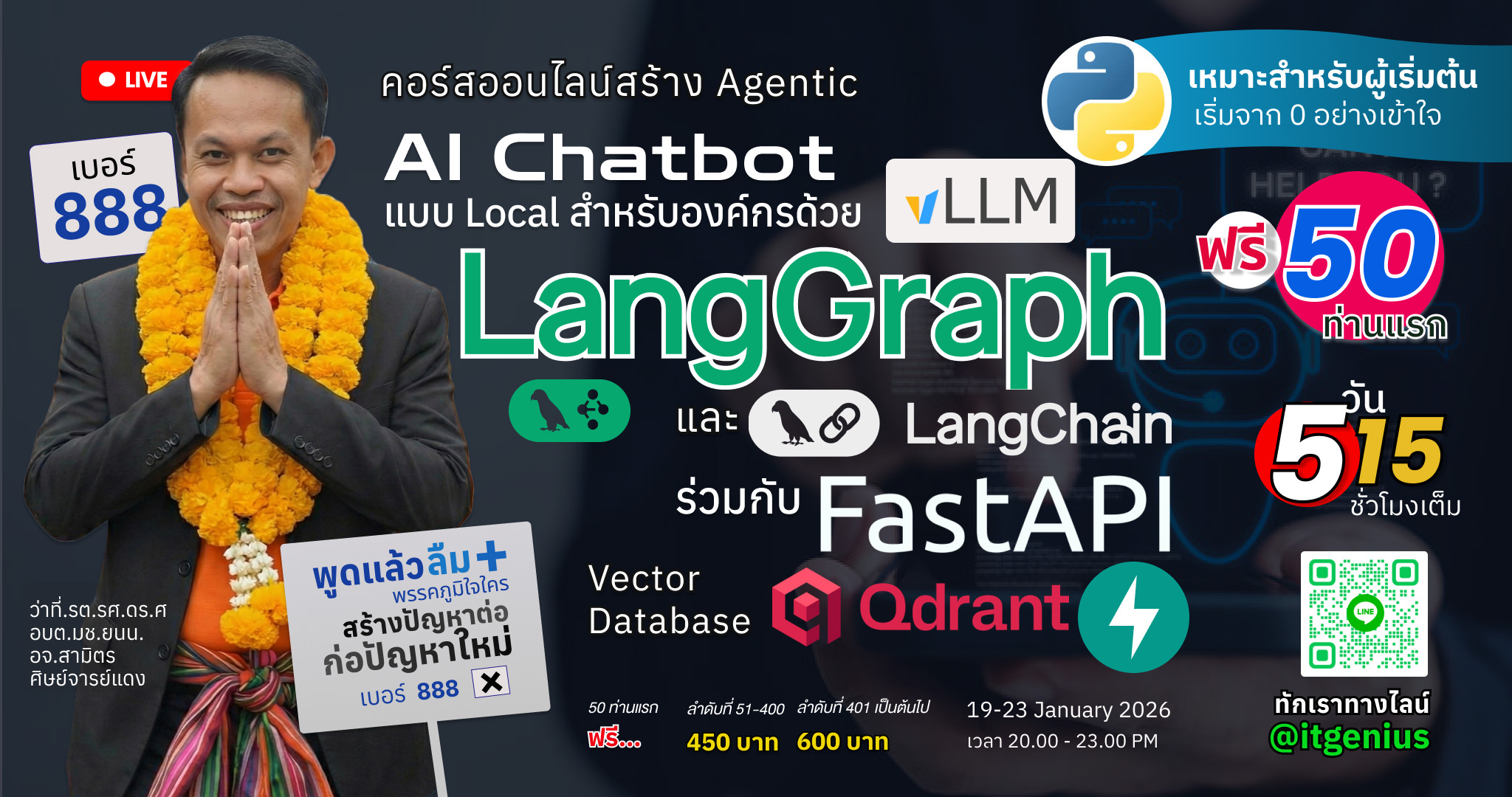

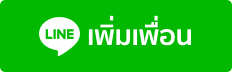

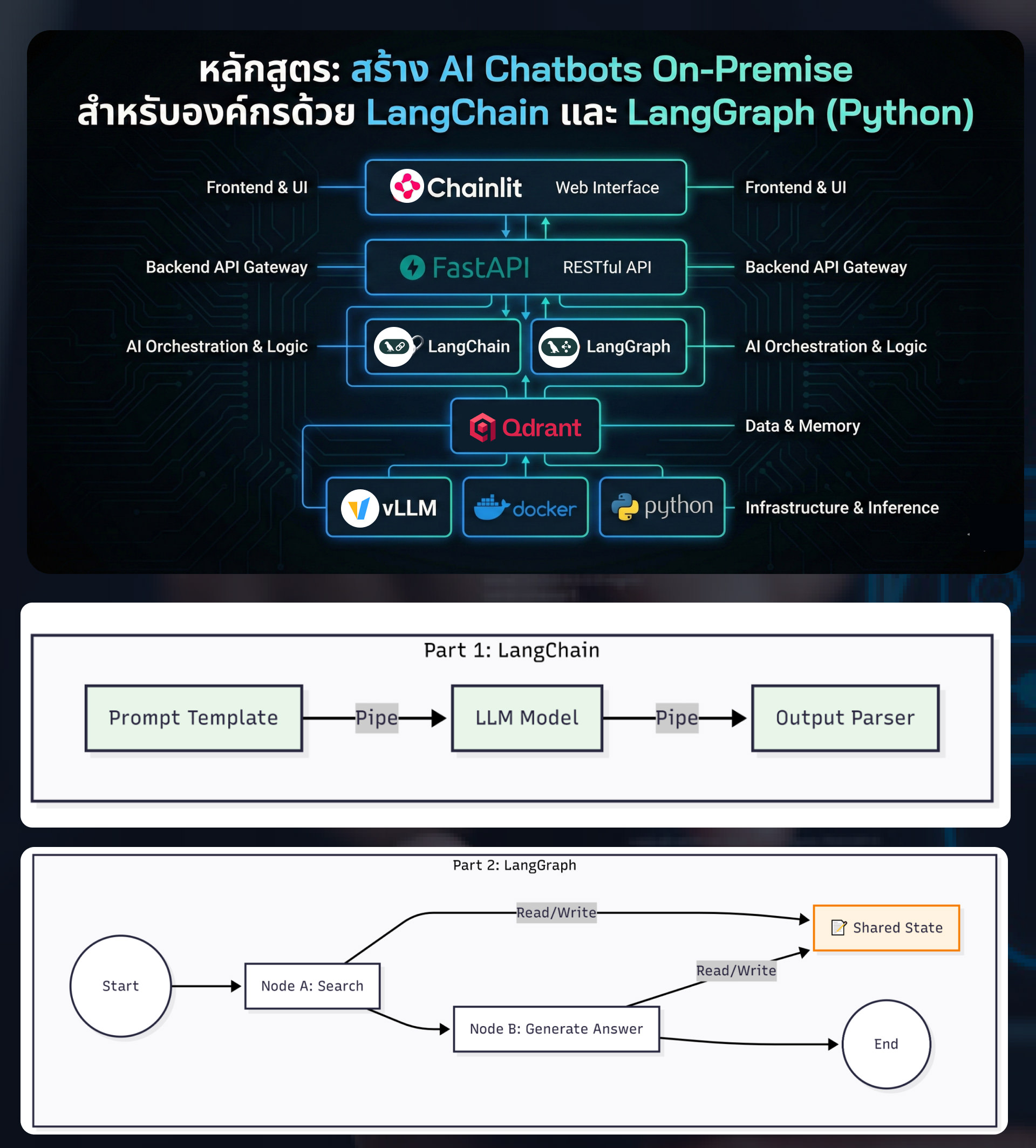

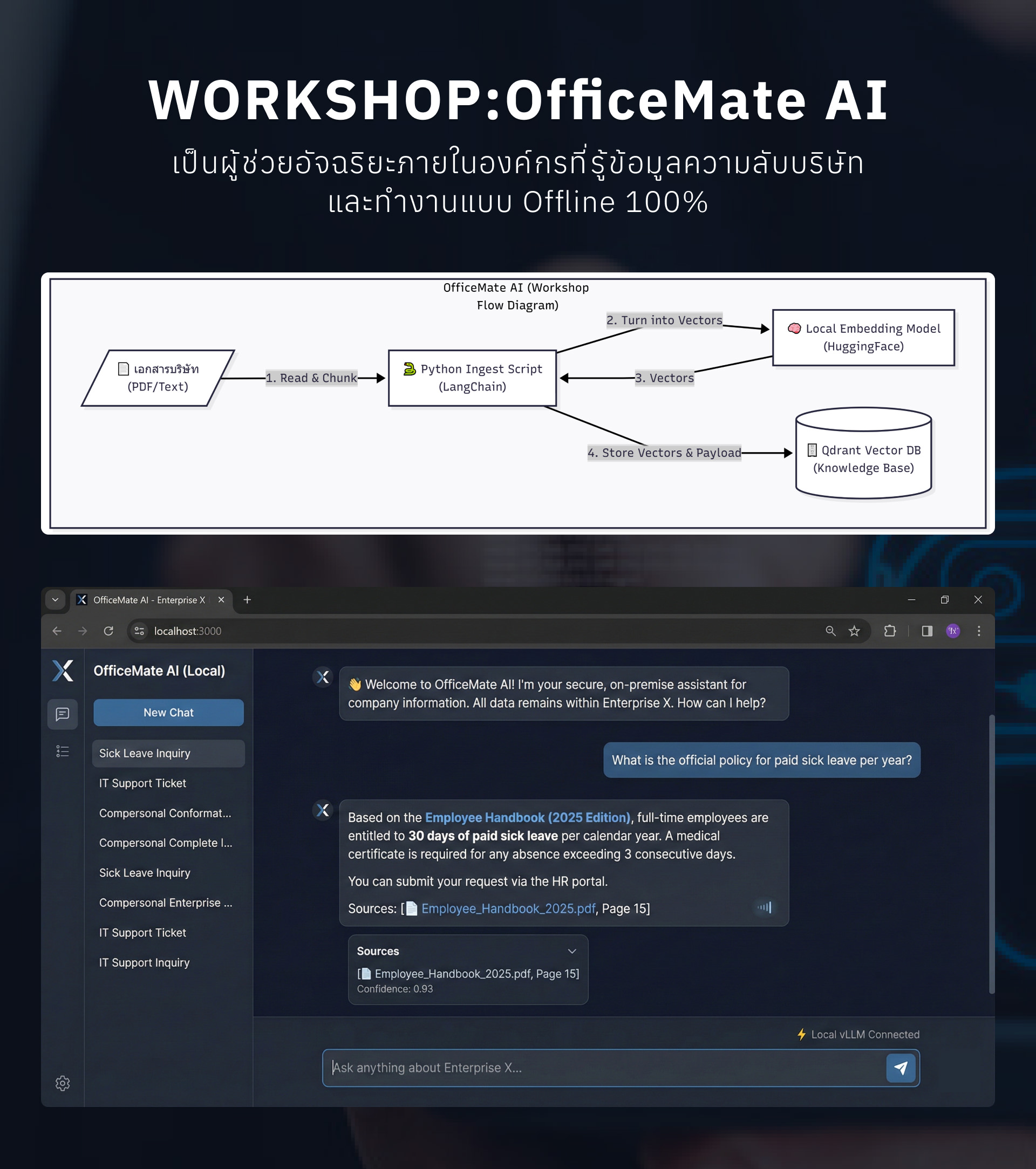

ในยุคที่ Artificial Intelligence (AI) เข้ามามีบทบาทสำคัญในการขับเคลื่อนธุรกิจ หลายองค์กรเริ่มกังวลเรื่องความปลอดภัยและความเป็นส่วนตัวของข้อมูล (Data Privacy) เมื่อต้องส่งข้อมูลสำคัญไปประมวลผลบน Cloud API สาธารณะ หลักสูตรนี้จึงถูกออกแบบมาเพื่อแก้ปัญหานี้โดยเฉพาะ ด้วยการสอนสร้างระบบ "Local AI" ที่ทำงานได้ภายในเซิร์ฟเวอร์ขององค์กรเอง 100% ตั้งแต่ระบบสมองกล (Inference Engine) ไปจนถึงฐานข้อมูลความรู้ (Vector Database)

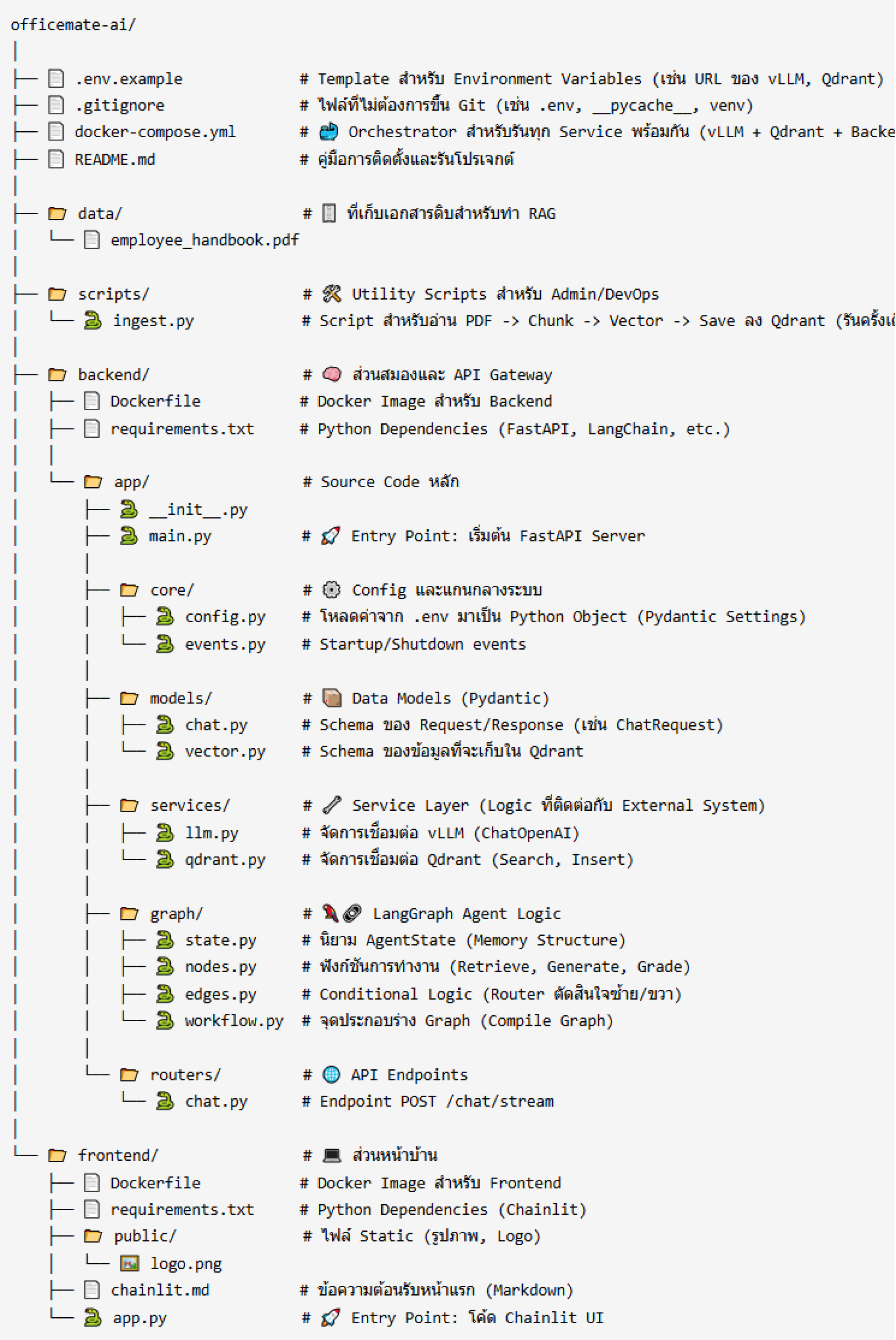

ผู้เรียนจะได้ลงมือปฏิบัติจริงในการพัฒนา AI Chatbot ที่มีความซับซ้อนระดับ Enterprise Grade โดยเปลี่ยนจากการเขียน Script ธรรมดา มาสู่การวางสถาปัตยกรรมแบบ Microservices ที่ยืดหยุ่นและขยายผลได้จริง เรียนรู้การใช้ vLLM เพื่อรันโมเดลภาษาขนาดใหญ่ให้ประมวลผลได้รวดเร็ว, การใช้ Qdrant จัดการความรู้เฉพาะทางขององค์กร (RAG), การใช้ LangGraph สร้าง Flow การตัดสินใจที่ชาญฉลาด แทนการเขียน Chain แบบเดิม และเชื่อมต่อระบบทั้งหมดผ่าน FastAPI และ Docker เพื่อให้พร้อมนำไปติดตั้งใช้งานจริง (Deployment) ได้ทันที

*** หมายเหตุ หลักสูตรนี้เน้นการใช้งาน LangChain และ LangGraph ร่วมกับ Python เพื่อสร้าง AI Chatbot ที่ทำงานได้ภายในองค์กรอย่างปลอดภัยและมีประสิทธิภาพ โดยใช้ Ollama, vLLM และ Qdrant เป็นเทคโนโลยีหลัก ผู้เรียน ไม่จำเป็น ต้องมีคอมพิวเตอร์ที่มี GPU ก็สามารถเรียนรู้ได้ผ่าน Google Colab (ฟรี)

หลักสูตรนี้พร้อมเรียนรู้ สามารถทักไลน์ด้านล่างเพื่อสั่งซื้อวิดีโอการอบรมได้ทันที

วิดีโอบันทึกการอบรม AI Chatbot On-Premise Python Stack

สำหรับท่านที่ต้องการซื้อในนามนิติบุคคล สามารถซื้อได้ในราคา 6,500 บาท (ยังไม่รวมภาษีมูลค่าเพิ่ม 7%)

การอบรมในหลักสูตรนี้เป็นการสอนสดออนไลน์ ผ่านโปรแกรม Zoom Meeting และมีการบันทึกการอบรมส่งให้ดูย้อนหลังทั้งหลักสูตร

อ.สามิตร โกยม (สถาบันไอทีจีเนียส)

อ.สามิตร โกยม (สถาบันไอทีจีเนียส)สวัสดีครับ ผมอาจารย์สามิตร โกยม - ผู้สอนหลักสูตรนี้ครับ ผมจบการศึกษาระดับปริญญาโทด้านเทคโนโลยีสารสนเทศ จากมหาวิทยาลัยพระจอมเกล้าพระนครเหนือ และอยู่ในวงการพัฒนาโปรแกรมและไอทีมากว่า 15 ปีแล้ว

ในยุคที่แอปพลิเคชันและเว็บไซต์ต้องสื่อสารกับระบบหลังบ้านด้วย API เป็นหลัก การพัฒนา REST...

ยินดีต้อนรับสู่ยุคที่ AI ไม่ได้เป็นเพียงแชทบอทถาม-ตอบ แต่ก้าวสู่การเป็น Agentic AI ที่...

ในยุคของ Cloud-Native และ DevOps การทำงานแบบ Container กลายเป็นหัวใจสำคัญของนักพัฒนา Do...

เบื่อไหมกับขั้นตอนการ Deploy ที่ซ้ำซาก, เชื่องช้า และเต็มไปด้วยความเสี่ยง? ในโลกการพัฒน...

ในยุคดิจิทัลที่องค์กรต่างขับเคลื่อนด้วยข้อมูล การปลดล็อกศักยภาพของข้อมูลภายในองค์กรให้พ...

"คิดถึง Microservice คิดถึง Spring Boot" ในปัจจุบัน การพัฒนาซอฟต์แวร์แบบ Microservice ไ...

เบื่อกับงานเดิมๆ ที่ต้องทำซ้ำทุกวันใช่ไหม ? อยากเพิ่มเวลาให้ตัวเองเพื่อโฟกัสกับงานที่สำ...

ยินดีต้อนรับสู่โลกของ Rust Programming ภาษาโปรแกรมมิ่งสมัยใหม่ที่ได้รับการโหวตจากนักพัฒ...

ในยุคที่การพัฒนา Web Application ได้รับความนิยมและพัฒนาอย่างรวดเร็ว หลักสูตร “Full Stac...

ปัจจุบันการพัฒนาเว็บแอปพลิเคชันแบบ Full Stack กำลังเป็นที่นิยม โดยเฉพาะ Laravel 12 ที่ท...

ในยุคดิจิทัลที่การพัฒนาเว็บและแอปพลิเคชันเป็นหัวใจของเทคโนโลยี TypeScript ได้กลายเป็นภา...

ในยุคที่เว็บไซต์เป็นหัวใจสำคัญของการสื่อสารและธุรกิจ การออกแบบเว็บไซต์ที่มีประสิทธิภาพแ...

หลักสูตร "Full Stack with Docker 2025" ถูกออกแบบมาเพื่อผู้เริ่มต้นและผู้ที่ต้องการพัฒนา...

หลักสูตร "ออกแบบเว็บและโมบายแอพด้วย Figma 2025" นี้เหมาะสำหรับผู้ที่สนใจเรียนรู้การออกแ...

หลักสูตร "Workshop Python Django 5 with Next.JS 15 and Supabase" ออกแบบมาเพื่อผู้ที่สนใ...

หลักสูตร "Basic React Native with Expo" นี้ถูกออกแบบมาเพื่อให้ผู้เรียนได้เรียนรู้การพัฒ...

หลักสูตร Basic Vue and Nuxt 3 with Prisma and Supabase นี้ถูกออกแบบมาเพื่อให้ผู้เรียนที...

ในยุคที่แอปพลิเคชันมีความซับซ้อนและต้องปรับเปลี่ยนอย่างรวดเร็ว Kubernetes (K8s) ได้กลาย...

ESP32 เป็นไมโครคอนโทรลเลอร์ที่มีความสามารถสูงและได้รับความนิยมอย่างแพร่หลายในวงการพัฒนา...

ภาษา Go มีข้อดีหลายประการที่ทำให้เป็นตัวเลือกที่น่าสนใจสำหรับการพัฒนาเว็บแอปพลิเคชันแบบ...